Los deepfakes de IA no estaban en el radar de riesgo de las organizaciones hace poco tiempo, pero en 2024, están subiendo de rango. Dado el potencial de los deepfakes de IA para causar cualquier cosa, desde una caída del precio de las acciones hasta una pérdida de confianza en la marca a través de información errónea, es probable que sigan siendo un riesgo durante algún tiempo.

Robert Huber, director de seguridad y jefe de investigación de la empresa de seguridad cibernética Tenable, argumentó en una entrevista con TechRepublic que los deepfakes de IA podrían ser utilizados por una variedad de actores maliciosos. Si bien las herramientas de detección aún están madurando, las empresas de APAC pueden prepararse agregando deepfakes a sus evaluaciones de riesgos y protegiendo mejor su propio contenido.

En última instancia, es probable que haya más protección para las organizaciones cuando las normas internacionales converjan en torno a la IA. Huber pidió a los actores de plataformas tecnológicas más grandes que avancen con una identificación más sólida y clara del contenido generado por IA, en lugar de dejar esto en manos de usuarios individuales no expertos.

Los deepfakes de IA son un riesgo creciente para la sociedad y las empresas

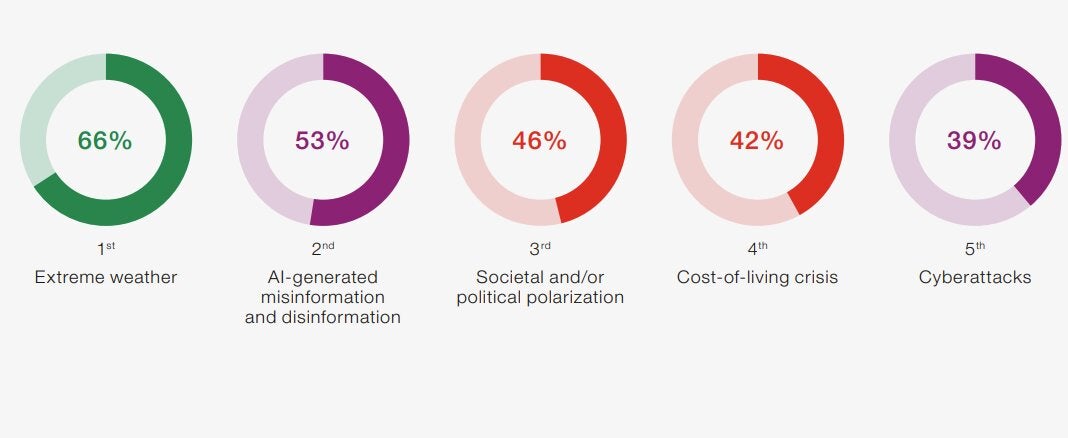

El riesgo de desinformación y desinformación generadas por la IA se está convirtiendo en un riesgo global. En 2024, tras el lanzamiento de una ola de herramientas de IA generativa en 2023, la categoría de riesgo en su conjunto fue el segundo mayor riesgo en el Informe de riesgos globales 2024 del Foro Económico Mundial (Figura A).

Figura A

Más de la mitad (53%) de los encuestados, que pertenecían al sector empresarial, académico, gubernamental y de la sociedad civil, mencionaron como un riesgo la información errónea y la desinformación generada por la IA, que incluye los deepfakes. La desinformación también fue considerada el mayor factor de riesgo en los próximos dos años (Figura B).

Figura B

Las empresas no se han apresurado a considerar el riesgo de falsificación de la IA. Encuesta global de gestión de riesgos de Aonpor ejemplo, no lo menciona, aunque a las organizaciones les preocupa la interrupción del negocio o el daño a su marca y reputación, que podría ser causado por la IA.

Huber dijo que el riesgo de falsificaciones profundas de IA aún es emergente y se está transformando a medida que los cambios en la IA se producen a un ritmo rápido. Sin embargo, dijo que es un riesgo que las organizaciones de APAC deberían tener en cuenta. “Esto no es necesariamente un riesgo cibernético. Es un riesgo empresarial”, dijo.

Los deepfakes de IA proporcionan una nueva herramienta para casi cualquier actor de amenazas

Se espera que los deepfakes de IA sean otra opción que cualquier adversario o actor de amenazas pueda utilizar para lograr sus objetivos. Huber dijo que esto podría incluir estados nacionales con objetivos geopolíticos y grupos activistas con agendas idealistas, con motivaciones que incluyen ganancias financieras e influencia.

“Aquí abarcarás toda la gama, desde grupos de estados nacionales hasta un grupo que tiene conciencia ambiental y piratas informáticos que solo quieren monetizar los depfakes. Creo que es otra herramienta más en la caja de herramientas para cualquier actor malintencionado”, explicó Huber.

Ver cómo La IA generativa podría aumentar la amenaza global del ransomware

El bajo costo de los deepfakes significa bajas barreras de entrada para actores maliciosos

La facilidad de uso de las herramientas de IA y el bajo costo de producir material de IA significan que hay pocos obstáculos para que los actores malintencionados deseen hacer uso de nuevas herramientas. Huber dijo que una diferencia con el pasado es el nivel de calidad que ahora están al alcance de los actores de amenazas.

“Hace unos años, el [cost] La barrera de entrada era baja, pero la calidad también era mala”, dijo Huber. “Ahora el listón sigue siendo bajo, pero [with generative AI] La calidad ha mejorado mucho. Entonces, para la mayoría de las personas identificar un deepfake por sí mismas sin pistas adicionales, se está volviendo difícil hacerlo”.

¿Cuáles son los riesgos para las organizaciones de los deepfakes de IA?

Los riesgos de los deepfakes de IA son “tan emergentes”, dijo Huber, que no están en las agendas de evaluación de riesgos organizacionales de APAC. Sin embargo, haciendo referencia al reciente ciberataque patrocinado por el Estado contra Microsoft, que la propia Microsoft informó, invitó a la gente a preguntar: ¿Y si fuera un deepfake?

“Ya sea por desinformación o por influencia, Microsoft está pujando por grandes contratos para su empresa con diferentes gobiernos y motivos en todo el mundo. Eso hablaría de la confiabilidad de una empresa como Microsoft, o se aplicaría a cualquier gran organización tecnológica”.

Pérdida de contratos empresariales.

Las empresas con fines de lucro de cualquier tipo podrían verse afectadas por el material deepfake de IA. Por ejemplo, la producción de información errónea podría causar dudas o pérdida de contratos en todo el mundo o provocar preocupaciones o reacciones sociales hacia una organización que podrían dañar sus perspectivas.

Riesgos de seguridad física

Los deepfakes de IA podrían añadir una nueva dimensión al riesgo clave de interrupción del negocio. Por ejemplo, la información errónea procedente de la IA podría provocar un motín o incluso la percepción de un motín, provocando peligro para las personas físicas o las operaciones, o simplemente la percepción de peligro.

Impactos de marca y reputación

Forrester publicó una lista de posibles estafas deepfake. Estos incluyen riesgos para la reputación y la marca de una organización o la experiencia de los empleados y los recursos humanos. Un riesgo fue la amplificación, donde los deepfakes de IA se utilizan para difundir otros deepfakes de IA, llegando a una audiencia más amplia.

Impactos financieros

Los riesgos financieros incluyen la capacidad de utilizar deepfakes de IA para manipular los precios de las acciones y el riesgo de fraude financiero. Recientemente, un empleado de finanzas de una empresa multinacional en Hong Kong fue engañado para que pagara a delincuentes 25 millones de dólares estadounidenses (40 millones de dólares australianos) después de que utilizó una sofisticada estafa de IA para hacerse pasar por el director financiero de la empresa en una videoconferencia.

El juicio individual no es una solución deepfake para las organizaciones

El gran problema para las organizaciones de APAC es que la detección de deepfake mediante IA es difícil para todos. Si bien los reguladores y las plataformas tecnológicas se ajustan al crecimiento de la IA, gran parte de la responsabilidad de identificar los deepfakes recae en los propios usuarios individuales, en lugar de en intermediarios.

Esto podría hacer que las creencias de individuos y multitudes impacten a las organizaciones. Se pide a las personas que decidan en tiempo real si una historia dañina sobre una marca o un empleado puede ser cierta o falsa, en un entorno que podría incluir información errónea en los medios y las redes sociales.

Los usuarios individuales no están preparados para separar los hechos de la ficción.

Huber dijo que esperar que las personas distingan qué es un deepfake generado por IA y qué no es “problemático”. En la actualidad, los deepfakes de IA pueden ser difíciles de discernir incluso para los profesionales de la tecnología, argumentó, y las personas con poca experiencia en identificarlos tendrán dificultades.

“Es como decir: 'Vamos a capacitar a todos para que comprendan la seguridad cibernética'. Ahora, el ACSC (Centro Australiano de Seguridad Cibernética) publica una gran cantidad de excelentes orientaciones para la seguridad cibernética, pero ¿quién realmente lee eso más allá de las personas que realmente están en el espacio de la ciberseguridad? preguntó.

El sesgo también es un factor. “Si estás viendo material importante para ti, traes prejuicios; es menos probable que te concentres en los matices de los movimientos o gestos, o en si la imagen es 3D. No estás usando esos sentidos arácnidos y buscando anomalías si lo que te interesa es el contenido”.

Las herramientas para detectar deepfakes de IA se están poniendo al día

Las empresas de tecnología se están moviendo para proporcionar herramientas para hacer frente al aumento de los deepfakes de IA. Por ejemplo, la herramienta FakeCatcher en tiempo real de Intel está diseñada para identificar deepfakes evaluando el flujo sanguíneo de los seres humanos en videos usando píxeles de video, identificando falsificaciones usando “lo que nos hace humanos”.

Huber dijo que las capacidades de las herramientas para detectar e identificar deepfakes de IA aún están surgiendo. Después de sondear algunas herramientas disponibles en el mercado, dijo que no había nada que recomendaría en particular en este momento porque “el espacio se está moviendo demasiado rápido”.

¿Qué ayudará a las organizaciones a combatir los riesgos de falsificación de la IA?

Es probable que el aumento de los deepfakes de IA conduzca a un juego del “gato y el ratón” entre actores maliciosos que generan deepfakes y aquellos que intentan detectarlos y frustrarlos, dijo Huber. Por esta razón, es probable que las herramientas y capacidades que ayudan a detectar los deepfakes de IA cambien rápidamente, a medida que la “carrera armamentista” crea una guerra por la realidad.

Hay algunas defensas que las organizaciones pueden tener a su disposición.

La formación de normas regulatorias internacionales de IA.

Australia es una jurisdicción que busca regular el contenido de IA a través de medidas como marcas de agua. A medida que otras jurisdicciones de todo el mundo avanzan hacia un consenso sobre la gestión de la IA, es probable que haya convergencia sobre los enfoques de mejores prácticas para respaldar una mejor identificación del contenido de la IA.

Huber dijo que si bien esto es muy importante, hay clases de actores que no seguirán las normas internacionales. “Tiene que haber un entendimiento implícito de que todavía habrá personas que harán esto independientemente de las regulaciones que implementemos o de cómo tratemos de minimizarlo”.

VER: Un resumen de las nuevas normas de la UE que rigen la inteligencia artificial

Grandes plataformas tecnológicas identifican deepfakes de IA

Un paso clave sería que las grandes redes sociales y plataformas tecnológicas como Meta y Google combatieran mejor el contenido deepfake de IA y lo identificaran más claramente para los usuarios en sus plataformas. Asumir una mayor parte de esta responsabilidad significaría que los usuarios finales no expertos, como organizaciones, empleados y el público, tendrían menos trabajo que hacer para tratar de identificar si algo es un deepfake.

Huber dijo que esto también ayudaría a los equipos de TI. Tener grandes plataformas tecnológicas que identifiquen los deepfakes de IA en la vanguardia y armar a los usuarios con más información o herramientas quitaría la tarea a las organizaciones; Se necesitaría menos inversión en TI para pagar y administrar herramientas de detección de deepfake y la asignación de recursos de seguridad para administrarlas.

Agregar deepfakes de IA a las evaluaciones de riesgos

Es posible que las organizaciones de APAC pronto deban considerar hacer que los riesgos asociados con las falsificaciones de IA formen parte de los procedimientos regulares de evaluación de riesgos. Por ejemplo, Huber dijo que es posible que los organisatinos deban ser mucho más proactivos a la hora de controlar y proteger el contenido que las organizaciones producen tanto interna como externamente, así como documentar estas medidas para terceros.

“La mayoría de las empresas de seguridad maduras realizan evaluaciones de riesgos de los proveedores por parte de terceros. Nunca he visto ningún tipo de preguntas relacionadas con cómo están protegiendo su contenido digital”, dijo. Huber espera que las evaluaciones de riesgos de terceros realizadas por empresas de tecnología pronto necesiten incluir preguntas relacionadas con la minimización de los riesgos que surgen de los deepfakes.